はじめに

こんにちは!

最近、人工知能や機械学習に興味を持ち始めた方も多いのではないでしょうか?

特に、大規模言語モデル(LLM)の進化は目覚ましく、私たちの日常生活にも大きな影響を与えています。

しかし、「LLMって難しそう…」「自分のPCで動かせるの?」と思っている方も多いはず。

そんな方々に朗報です!

今回は、WindowsパソコンにOllamaというツールを使って、簡単にローカルLLMを構築する方法をご紹介します。

プログラミング初心者の方でも、この記事を見て一緒にOllamaを使い倒しましょう!

Ollamaについて

Ollamaとは、ローカル環境で大規模言語モデルを簡単に実行できるオープンソースのツールです。

従来、LLMの実行には高性能なサーバーや複雑な設定が必要でしたが、Ollamaはこれらの障壁を大幅に下げました。

以下がOllamaの主な特徴です。

- 使いやすさ:コマンドラインから簡単に操作できます。

- 軽量:一般的な家庭用PCでも動作します。

- カスタマイズ性:様々なLLMモデルに対応しています。

- プライバシー:すべてローカルで動作するため、データがインターネットに送信されません。

Ollamaを使えば、ChatGPTのようなAIアシスタントを自分のPC上で動かすことができるんです。

とても便利そうですね!

Ollamaの導入方法

- Ollamaをダウンロード

公式サイトからWindowsマークをクリックしてOllamaをダウンロードしましょう。

Ollamaがダウンロードできたらzipファイルを解凍して、Ollamaを起動しましょう。

起動ができたらWindowsの検索欄に「cmd」と入力してコマンドプロンプトを起動します。

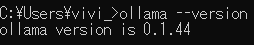

コマンドプロンプトが開いたら次のコマンドを入力してEnterキーをクリックします。

ollama --version

画像のようにバージョン情報が表示されていればWindowsにダウンロードが完了しています!

- Ollamaでモデルをダウンロード

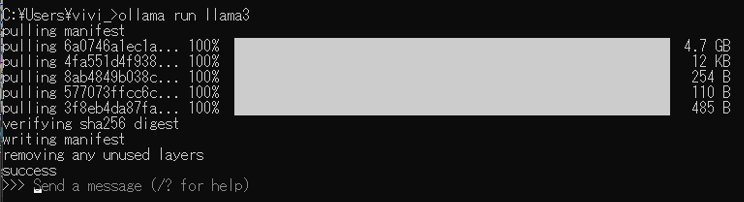

次のコマンドを入力してLLMで利用するモデルをダウンロードします。

ollama run llama3

コマンドを実行すると画像のようにダウンロードが開始します。5分程度で完了するかと思います。

これで準備完了です!

Ollamaの使用感想

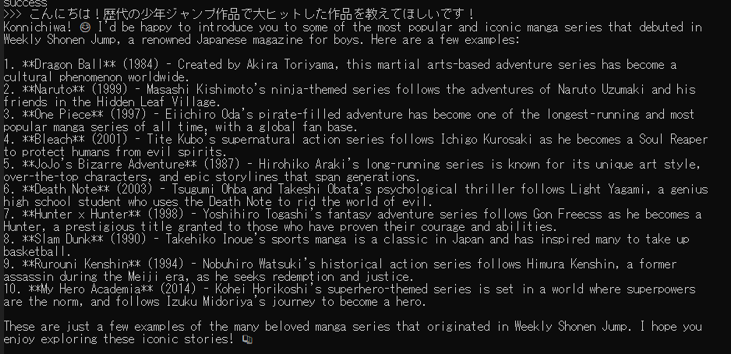

次の質問をしてみました。

「こんにちは!歴代の少年ジャンプ作品で大ヒットした作品を教えてほしいです!」

短い文章が5つくらいかなと思っていました。

実際の回答では10作品の年代とその特徴についてちゃんと書かれていました。

GPUが搭載されていないPCの場合は生成に時間がかかってしまうのが難点ですが、簡単な文章生成に関しては悪くなさそうです。

先述したOllamaの特徴であるLLMのモデルを変更して利用もできるので、用途に応じたモデルをローカル環境で使用できるのはうれしいですね!